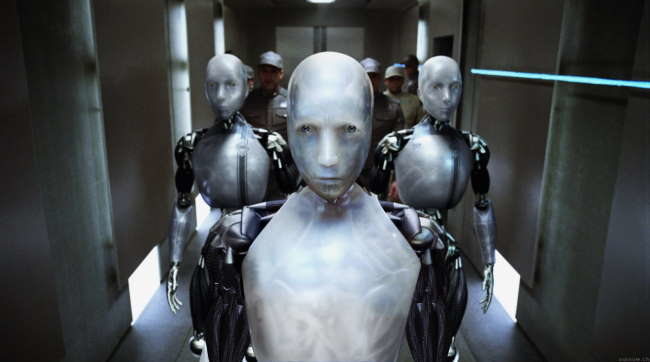

Cada día estamos acercándonos a lo que hace pocos años considerábamos el futuro. Uno de los "escenarios futuristas" más populares es en donde los robots, que nosotros mismos creamos, se vuelven en nuestra contra aniquilando la población humana. Es por eso que la Oficina de Investigación Naval de Estados Unidos ha publicado un reporte en donde se plantean todo tipo de escenarios donde los robots del futuro pueden ser un peligro para la humanidad. Claro que esto no quiere decir que no los van a crear, sino que van a necesitar un “código guerrero” para controlarlos.

Desde novelas como Frankenstein de Mary Shelley hasta las novelas de Isaac Asimov, y más allá, hemos temido el día que nuestra propia creación se vuelva en nuestra contra. Y lo que hasta ayer era pura ficción, parecería ser que de a poco está comenzando a preocupar a las fuerzas militares del mundo. En un reporte que circuló en el interior de la Oficina de Investigación Naval se plantea la necesidad de desarrollar un código guerrero para los robots militares que lucharán en las guerras del mañana.

Por supuesto que sería mucho más constructivo enviar un reporte para evitar “las guerras del mañana”, pero como el ser humano generalmente funciona como un robot descompuesto, ahora la preocupación gira alrededor de robots futuristas super-inteligentes que podrían ser una amenaza para la humanidad. Aunque parezca sacado de una película de ciencia ficción, este es el primer reporte de su tipo que se haya hecho público y puede ser leído aquí.

Este reporte plantea la necesidad de proteger a los civiles de los problemas que puede acarrear tener robots inteligentes que puedan tomar decisiones en el campo de batalla y así "preservar la vida humana". La solución a este problema, según el doctor Patrick Lin, compilador del reporte, sería programar las máquinas con una base de reglas sobre lo que está bien o mal en un período de guerra. Una especie de “Código del Guerrero”.

Estos códigos tendrían una similitud a las conocidas tres leyes de la robótica de Isaac Asimov, pero claro que hay varios problemas externos que Asimov no pudo prever en su momento, como hackers terroristas y problemas más comunes como malfuncionamiento del software base. En el reporte se cubren todo tipo de casos donde las cosas pueden salir mal. Se plantean los problemas políticos, sociales, éticos y legales que puede traer el perfeccionamiento de la tecnología robótica y también se plantean problemas como un robot perdiendo control en un lugar lleno de civiles, e ideas cómo si deberían tener “botones de autodestrucción”.

Patrick Lin dice que en la cultura general existe la idea equivocada de que los robots solo harán lo que están programados para hacer. Pero según, este experto esa idea es bastante vieja porque hoy en día los programas están compuestos por millones de líneas de código y son escritas por cientos de programadores y ninguno de ellos conocen el programa entero. En definitiva, nadie podría predecir cómo se comportarían las diferentes secciones del código sin antes probarlo extensamente en un campo de batalla.

Tal vez algunos piensen que ya pensar en esto puede ser un poco temprano, pero el Congreso de los Estados Unidos afirmó que, para 2010, un tercio de los aviones militares deben ser no-tripulados. Lo mismo se dijo de los vehículos de combate terrestres, pero para 2015. Lamentablemente, según Patrick Lin, una lista de mandatos como las reglas de la robótica de Asimov no sería suficiente, porque al ser robots militares, sería imposible que sean pacifistas. En ese caso se necesitaría un código guerrero (o sea, algo que hasta un soldado pueda comprender).

En definitiva, lo que intenta hacer el código es evitar que los robots del futuro cometan las mismas atrocidades que ya hemos cometido nosotros… pero con palabras más bonitas.

jaja primero!!!! XD muy buen articulo

Que dice el doctor nosecuanto que una maquina no se limita a hacer lo que esta programada a hacer??? Este tipo es un imbecil, si bien no predecimos como funcionara un software, un programa JAMAS hace algo que no esta programado para hacer…

Justamente esto iba a opinar yo tambien. Este tipo Lin es un palmito, TODO SOFTWARE hace SOLO -o, si prefieren, A LO SUMO- lo que esta programado para hacer. En todo caso el problema seria que lo programen mal. Pero esa "idea" es totalmente acertada y correcta.

Lo jodido es que seguramente estaran diseñados para aprender xD

Concuerdo con ustedes, de donde carajo sacaron a este tipo? se nota que no sabe ni una pizca de Inteligencia Artificial.

No importa cuanto robots se usen en guerras al final sera el humano en que peleara mano a mano para protegerse.

Siguiendo la linea argumental de muchas peliculas, llegado el caso de que una IA sea tan fuerte que pueda traspasar su programacion que seria de el?? Pediria que se le tratase como a un ser vivo? o tendria una mente retorcida que le obligaria a crear un ejercito para destruir la civilizacion humana y eliminar a todo hombre, mujer, niños, perros, gatos(Que se jodan los gatos) en una orgia de tripas y sangre??? Puede parecer estupido pero grandes problemas han surgido de la frase "Es teoricamente imposible que…"

Si algo aprendimos de matrix, es que varios humanos pendejetes no estaran de acuerdo cuando la IA tenga conciencia de su existencia y quiera un trato igualitario.

Y sí, al final pelearemos mano con metal xD

no se preocupen que ahora migraron todo a software libre.

tal vez apoye en cierto grado su comentario, un software hace lo que le indique el programador que haga, pero esto no significa que va actuar exactamente, pareciera que me contradigo pero nop, en mi experiencia como programador al momento de correr por primera vez los procesos la gran parte hace cosas "inesperadas" ya sea por errores en la "logica" del codigo o por causas externas, un programa puede hacer cosas que nosotros no queramos, simplemente con equivocarte en un solo operador puedes estar indicandole al programa otra cosa muuuy diferente, en conclucion un programa obedece al programador la cuestion es, que tal si el programador se equivoca o no mide el alcanze del programa??

otra cosa, supongo que los militares no programan estructuradamente, si se enfocan mas a la inteligencia artificial las cosas son muy diferentes, haya se programa para que el codigo o este "ser" que se crea, actue como el "quiera" tome las decisiones que mas le parezcan, quiza por errores humanos el sistema puede abrirse camino y hacer cosas indeseadas.

PD: si un robot se pone loco abremos cientos de personas dispuestos a tirar sus sistemas centrales o no amigos??, estoy queriendo iniciar un clan u organizacion para programar y construir robots que contrarresten a estos robots que algun dia pueden salir defectuosos, claro estaran siempre bajo nuetro control 🙂

¿Y que hay de los robots que "aprenden"? Esa es la parte más fundamental de la AI, y justamente podría hacer que los robots "aprendan" lo que no le dió su programador.

Pues siento decirte que la ciencia de la inteligencia artificial se encuentra aun muy lejos de conseguir desarrollar los algoritmos para que aprendan, te lo dice alguien que actualmente estudia esa rama de la computacion.

Nada como las tres leyes de la robótica xD

Personalmente se me hace una burrada usar robots con IA para fines militares. El problema esta en las divisiones politicas y la desigualdad, que deviene en una falta de educación… en fin, que si usamos robots para diversión (ya sabes, con esas sierras y lanza llamas) se fomenta la investigación y da lugar a la salida de la tensión.

Juas, sería un partido de futbol pero más geek xD. Y es que es feo la perdida humana, uno lee "Aparece un muerto más enrollado en una cobija" y se pone a pensar en los familiares del pobre wey, de las cosas que pudo hacer para beneficiar al estúpido mundo.

Evitando que la pesadilla de Sarah Connorh se haga realidad

Uhmmmmm el ejercito estadounidense hoy por hoy utiliza "robots" (en realidad son minitorretas con ruedas) que las acampan y les indican la zona de rango y, ante todo lo que se acerque por el frente….. primero dispara y luego pregunta.

El problema está ahi, si se sigue evolucionando en el uso de armas y robots… Lo unico que nos espera es la ley de la DMA (destrucción mutua asegurada), con la cual, cuando tu fabriques un robot que mate a los mios, yo crearé un robot que mate al tuyo y a los tuyos… Vamos, lo que llevamos viendo desde que empezamos a usar piedras y palos contra nosotros mismos.

Ademas, si tenemos en cuenta que un robot maneja mucha mas cantidad de datos que nosotros en milisegundos y, que pueda encontrarse con otro robot contrario igual… que harán? se destruirán mutuamente o que? Eso sin contar los civiles, porque dudo mucho que les hagan un escaner a todos los civiles del pais en guerra para ver a quien tiene que disparar o no el robot (porque dudo mucho que a cierta distancia el robot "lea" si tiene restos de polvora o si lleva un arma encima, aunque lo segundo seria mas facil),

no se preocupen tanto que todo eso es pura realidad a muy poco tiempo tansolo el assimo

es algo de ello puede interactuar, y que mas que canbiar unas lineas de codigo para convertirlo en una maquina asesina

estaria muy bueno que existiesen para acabar un poco con la porqueria en todo el mundo asi podriamos convivir un poquitito mas en paz con nosotros mismos y asi nos dariamos cuenta de lo mucho que valemos los unos a los otros o es que me eh equivocado?…

ademas para que querriamos construir una gran maquina asesina de metal puro si con toda nuestra imaginacion ya emos acavado con toda la raza humana mucho antes de lo que todos se imaginaron… o es que me eh vuelto a equivocar…ahahah…?