En esta guía vamos a detallar los pasos para crear y utilizar de la mejor manera el archivo “robots.txt” ubicado en la raíz de una página web. El archivo robots.txt es la puerta de acceso para que los robots automatizados de los principales buscadores (principalmente el robot de Google) ingresen al sitio web o blog y los mismos comprueben el crecimiento de la información de la página web.

Pero si te preocupa que un robot ingrese a tu sitio web y tenga acceso libre a tu información, a continuación vamos a crear el archivo “robots.txt” que básicamente controlará al robot de los buscadores indicándole donde puede ingresar libremente y en donde tendrá prohibido el acceso.

Lo primero que tenemos que hacer es abrir un documento de texto desde el ordenador y nombrarlo “robot” y que tenga la extensión “.txt”; una vez que insertemos el código adecuado (dependiendo las necesidades del sitio), lo subimos a la raíz de la página web vía FTP.

Ahora si queremos bloquear una carpeta del sitio web, para que el robot de los buscadores no tengan acceso a la misma, le insertaremos este código al archivo “robots.txt”:

User-agent: *

Disallow: / confidencial.html

Disallow: / nombredelacerpeta /

En cambio si lo que buscamos es que el sitio web esté totalmente bloqueado y el robot no pueda ingresar a ninguna carpeta, contenido o archivo copiamos el siguiente código:

User-agent: *

Disallow: /

Y si lo que buscamos es tener una página web que no sea indexada por los buscadores web, insertamos el siguiente código:

User-agent: *

Disallow: / asunto-confidencial.html

Pero si lo que buscamos es restringirle a los buscadores algún acceso, pero que tengan acceso a los artículos, imágenes, el contacto y otras carpetas, insertamos el siguiente código:

User-agent: *

Allow: / articulo-web.html

Allow: / carpeta / contato.html

Allow: / imagenes /

Disallow: /

Y si lo que tenemos es un CMS (Joomla, WordPress, Drupal, etc.), tenemos que copiar este código:

User-agent: *

Disallow: /administrator/

Disallow: /cache/

Disallow: /cli/

Disallow: /components/

Disallow: /images/

Disallow: /includes/

Disallow: /installation/

Disallow: /language/

Disallow: /libraries/

Disallow: /logs/

Disallow: /media/

Disallow: /modules/

Disallow: /plugins/

Disallow: /templates/

Disallow: /tmp/

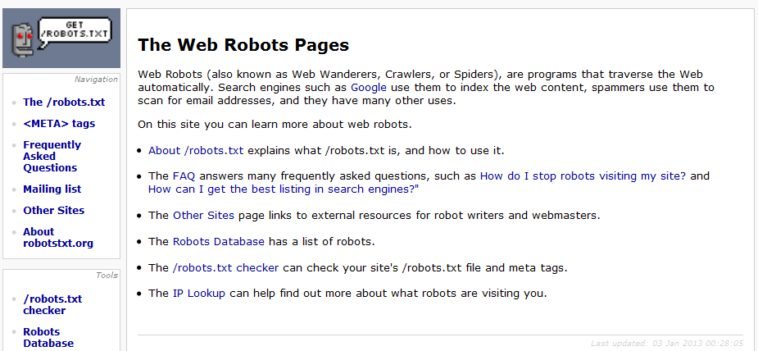

Con estos ejemplos podrás crear o personalizar el archivo robots.txt de una página web. Este archivo es importante tenerlo bien configurado si queremos que la página web tenga un buen posicionamiento web y llegar a los primeros puestos de los principales buscadores web. Para ampliar la información se pueden dirigir al sitio web oficial de “robottxt”.

Gracias por el artículo. Sin embargo, ¿No es "robots.txt" (en plural)?

muy util para todos nosotros que tenemos una web…

(sarcasmo)

¡Ojo! Cuando un usuario malintencionado quiere "husmear" en una web, lo primero que hace es mirar este fichero para ver qué es lo que el creador no quiere que se vea… Por no mencionar que hay buscadores "underground" que indexan primero lo que contiene este fichero… El robots NO BLOQUEA contenido, al contrario, atrae la atención.