El mundo de la informática tuvo muchas razones para festejar con el anuncio de un chip de 7 nanómetros fabricado por IBM, pero cerramos ese mismo artículo diciendo que si no surgía ningún imprevisto, la tecnología llegaría al mercado en 2017. Bueno… surgió un imprevisto. El CEO de Intel Brian Krzanich confirmó recientemente que la reducción a 10 nanómetros será demorada hasta la segunda mitad de 2017. Dicho de otro modo, habrá un «doble tock» en 14 nanómetros.

Se anunció tantas veces su desaparición, que el público en general comenzó a ver a los medios especializados como agoreros. La Ley de Moore lleva oficialmente entre nosotros poco más de cincuenta años, y a decir verdad no estuvo libre de modificaciones. La versión original hablaba de duplicar anualmente los componentes en un circuito integrado, pero en 1975 se ajustó el valor a la actualidad (en ese entonces) de los semiconductores, elevando el tiempo a dos años. Incluso el término «ley» se quedó pegado con el paso del tiempo. Técnicamente se trata de una proyección, pero con medio siglo de efectividad, resulta difícil no llamarla ley. Aún así, el propio Gordon Moore dijo en marzo pasado que su observación estará terminada «dentro de la próxima década». La industria ha implementado toda clase de técnicas para seguir reduciendo el tamaño de los componentes, y con el reciente anuncio de IBM, había esperanzas de una extensión.

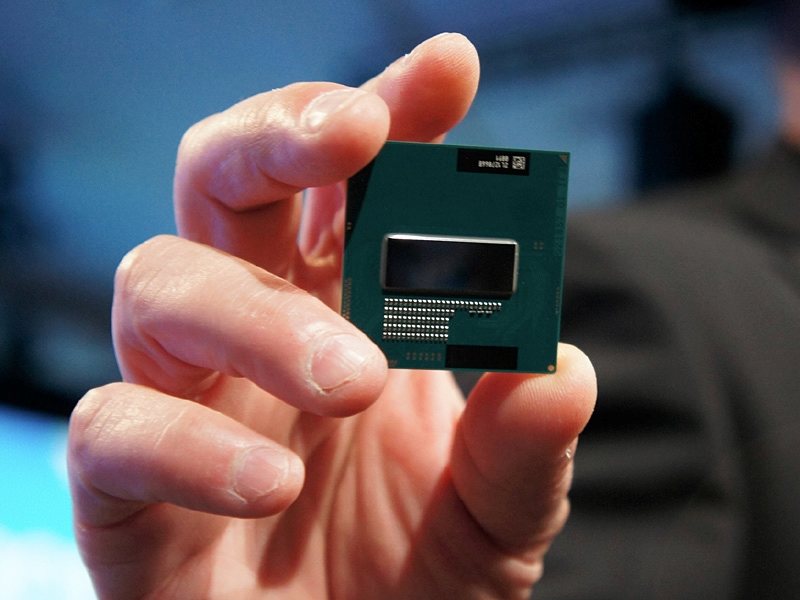

Sin embargo, Intel decidió arrojar un manto de sinceridad. A través de un reporte financiero, el CEO de Intel Brian Krzanich confirmó que habrá un retraso cercano a dos años en la implementación del llamado nodo de 10 nanómetros, el cual simbolizaría el debut de la arquitectura Cannonlake, nuevo tick en la estructura. Hoy estamos en lo que es Broadwell, también un tick, y compresión de Haswell a 14 nanómetros. En comparación con generaciones previas, la cantidad de procesadores Broadwell disponibles es relativamente baja, un detalle que se hace notar más entre los productos de escritorio. El propio Krzanich admitió que la migración a 14 nanómetros ha sido mucho más compleja de lo que se había calculado, y que los primeros indicios ya se manifestaron con la transición previa a 22 nanómetros.

¿Cómo queda el panorama? Para los próximos meses, todo seguirá igual: La arquitectura Broadwell será reemplazada por Skylake, nuevo diseño en 14 nanómetros que establece el tock, pero en vez de pasar a Cannonlake con 10 nanómetros, habrá una especie de «doble tock» con Kaby Lake, tercera arquitectura de 14 nanómetros que en teoría ofrecerá chips móviles y de escritorio como sus antecesores. Krzanich no cree que esto es el fin del sistema tick-tock, pero es un buen momento para pensar sobre el futuro. Nos hemos sentido muy cómodos con la estabilidad de la Ley de Moore. ¿Tal vez es hora de repensar a nuestros procesadores? ¿Será posible incrementar la superficie o explorar diseños 3D? Los comentarios están abiertos.

7 Comments

Leave a Reply