Existen juegos difíciles, juegos muy difíciles, y después aparece el Montezuma’s Revenge. Esta maravilla de la consola Atari 2600 (y otros sistemas) ha sido reconocida por su absoluta falta de piedad, con el pobre Panama Joe atrapado en una pesadilla de calaveras asesinas, portales láser, serpientes, arañas, caídas, y muerte, mucha muerte. La gente de Google lleva un largo tiempo enfrentando a su inteligencia artificial Deep-Q con el Montezuma’s Revenge, y sólo después de crear «curiosidad artificial» lograron que explore un máximo de 15 pantallas, cuando antes no recorría más de dos.

Volver corriendo de la escuela, ignorar la tarea, ir a jugar al fútbol, regresar todo sucio, mi madre gritando desde la cocina, sentarme frente al televisor, encender el clon de Atari 2600 que poseía en ese entonces… y convertir al Montezuma’s Revenge en un desafío personal. Porque definitivamente «era» personal, no tengan dudas. Creo que aún hoy mis padres están arrepentidos de haber comprado «ese aparato». El Montezuma’s Revenge fue uno de los responsables directos en la creación de un verdadero «cementerio de controles», ya que los destruía saltando calaveras. Con el paso del tiempo me hice bastante bueno en el juego… y un par de décadas después lo jugué en un emulador, sólo para redescubrir una verdad innegable: Me estoy volviendo viejo e inútil. Los «reflejos ninja de 8 años» habían desaparecido por completo. Si el Montezuma’s Revenge ya era algo inalcanzable para mí, imaginen a una inteligencia artificial tratando de descifrarlo.

De acuerdo a la gente de Google, su sistema Deep-Q la pasó muy mal con el Montezuma’s Revenge. El año pasado hablamos sobre su progreso, y las altas puntuaciones obtenidas en medio centenar de juegos para Atari 2600, sin embargo, su rendimiento en Montezuma’s Revenge fue nulo. Cero. Evidentemente algo fallaba en la metodología y el aprendizaje de la inteligencia artificial. La conclusión de Google fue que a Deep-Q le faltaba curiosidad, un estímulo extra que la ayude a enfocarse en la exploración, y «tratar de ganar» el juego tal y como un humano lo haría. Varios ajustes en el código y 100 millones de «cuadros de entrenamiento» después, Deep-Q sólo necesitó cuatro intentos para completar la primera pantalla del juego, cuando un año atrás no era capaz ni de sumar un solo punto.

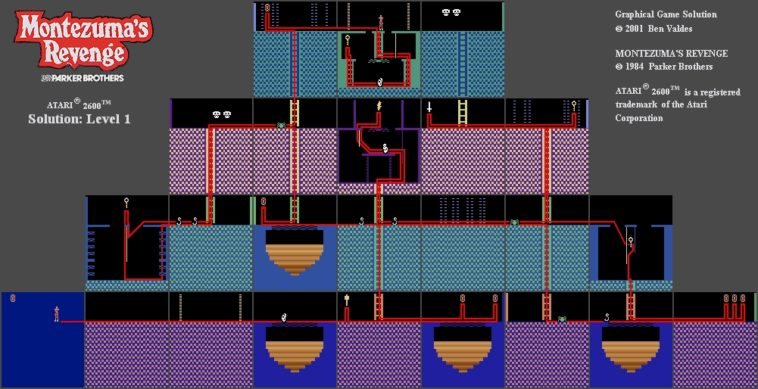

Con este nuevo perfil, Deep-Q llegó a explorar un total de quince pantallas sobre el total de 24 que componen el «nivel 1» del juego. O sea, aún sigue muy lejos de completarlo, pero la ambición de Deep-Q apunta mucho más alto de lo que imaginamos. Con cada nueva versión, la inteligencia artificial encuentra la manera de pulir habilidades, y después de lo que hicieron con AlphaGo, ya hablan de títulos como StarCraft para su siguiente fase. Calculo que alguien en Corea del Sur espera ese duelo con ansias…

3 Comments

Leave a Reply