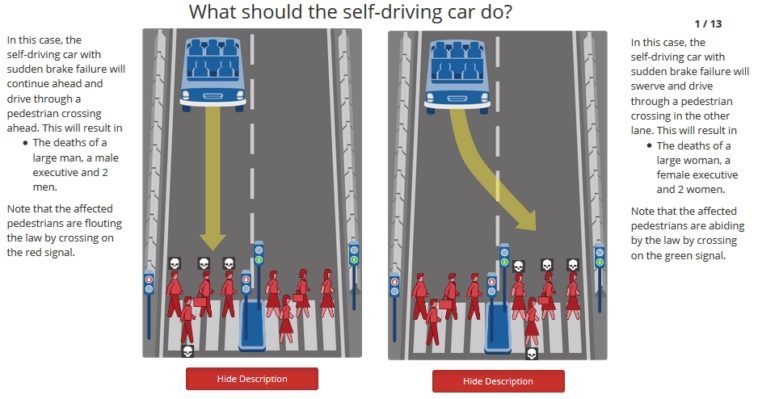

Eres un coche autónomo. En tu interior llevas tres pasajeros. Una falla catastrófica de los frenos impide que puedas frenar a tiempo en el semáforo, mientras otras tres personas cruzan la calle. Si atropellas a esas tres personas provocarás su muerte, pero tus pasajeros saldrán ilesos. En cambio, si decides maniobrar, salvarás a los peatones, y tus pasajeros morirán en el choque. ¿Qué harías? Este y otros ejercicios son explorados en el portal Moral Machine, que nos permite compartir una perspectiva humana para los conflictos morales que deberán enfrentar muchos sistemas automatizados.

«Kobayashi Maru». Un escenario en el que no se puede ganar. Una «prueba de carácter», de acuerdo a cierto capitán que resolvió dicho escenario… haciendo trampa. Ahora, el problema del Kobayashi Maru es que fue diseñado para poner bajo fuego lo que sin duda alguna son cualidades humanas, o en el caso específico de Star Trek, las cualidades de sus oficiales. ¿Pero qué pasa si colocamos a la lógica en esa situación? Unos y ceros. Inteligencias artificiales. En cuestión de milisegundos evaluarán todas las opciones disponibles, y probablemente escojan la más eficiente, o la más efectiva. Sin embargo, ¿qué hay de la moral y la ética detrás de esa opción? Esto no es una teoría. Las inteligencias artificiales tomarán decisiones de ese calibre muy pronto, cuando controlen coches, camionetas y camiones. El factor humano es el principal responsable por los accidentes de tránsito, pero las fallas mecánicas no desaparecerán. ¿Qué es «lo correcto»? ¿Cuál es «el mal menor»?

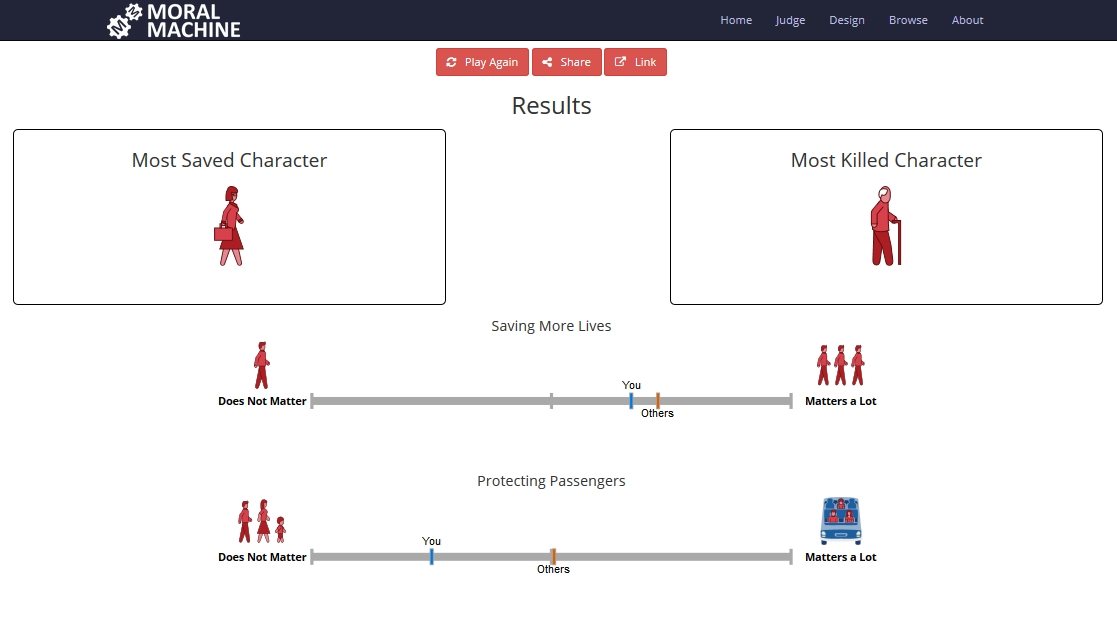

El portal Moral Machine desarrollado por el MIT nos ayuda a explorar la respuesta a ambas preguntas asumiendo el rol de observador externo ante un escenario que un coche autónomo debe resolver. Los ejercicios no dejan de ser «trampas binarias», ya que no hay alternativas, ni atajos, ni términos medios. Una u otra elección lleva inevitablemente a la muerte de alguien, sea persona o animal, pero también se incorporan otros elementos. ¿Qué vale más, la vida de una persona que cruza con el semáforo en rojo, o la de aquella que esperó su turno? En total, Moral Machine presenta trece ejercicios, y al final podremos apreciar un resumen de nuestras decisiones. Número de vidas salvadas, obediencia a la ley, preferencias de género o estatus social, y hasta el nivel de intervención son evaluados.

Cada ejercicio es generado de forma aleatoria, por lo que no existe nada parecido a un «resultado definitivo», y si decides comenzar desde cero, seguramente verás otros valores registrados. Tal y como lo indica el portal en su letra pequeña, Moral Machine no busca juzgar a nadie, sino compartir con el público la importancia y la complejidad detrás de la toma de decisiones éticas y morales por sistemas a cargo de inteligencias artificiales.

4 Comments

Leave a Reply