Después de haber generado millones y millones de imágenes, las inteligencias artificiales se preparan para ganar movimiento y dimensión. El rol del modelado 3D en la industria es gigantesco, y si una nueva plataforma logra dinamizar aún más el proceso de creación, podría iniciar una verdadera revolución. Con eso en mente descubrimos a Point-E, un sistema diseñado por OpenAI que genera modelos tridimensionales combinando texto y nubes de puntos.

Desde gatitos astronautas hasta escenas fantásticas repletas de detalles, los modelos generativos de imágenes han dado lugar a una explosión de actividad en la Web. Una parte del público se ha enfocado en debatir la situación legal y ética de algunos desarrollos, pero una cosa es segura: El avance de esta tecnología no va a detenerse.

¿Qué es lo que sigue en la lista? Además del vídeo, otra de las prioridades es el modelado 3D. Por lo general, las herramientas profesionales tienen una curva de aprendizaje bastante compleja, pero si el concepto de «texto-a-3D» se vuelve realidad, no sería descabellado hablar sobre una democratización del diseño tridimensional. En esa dirección apunta la gente de OpenAI tras confirmar la apertura de su proyecto Point-E, un equivalente a DALL-E para objetos 3D.

Point-E: De texto a objetos 3D, con inteligencia artificial

De acuerdo al paper oficial, una de las principales ventajas de Point-E es su velocidad. Mientras que DreamFusion de Google necesita una cantidad muy importante de tiempo y tarjetas gráficas para generar modelos, Point-E tarda menos de dos minutos sobre una unidad Nvidia V100. Jim Fan de Nvidia explica que Point-E es 600 veces más rápido que DreamFusion, aunque se ubica por debajo en calidad.

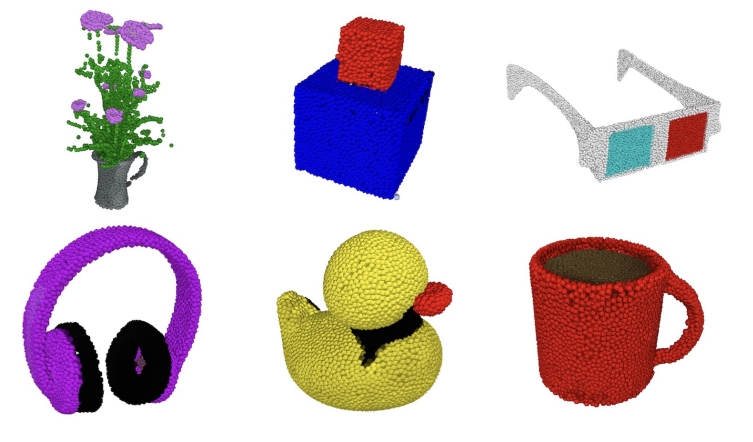

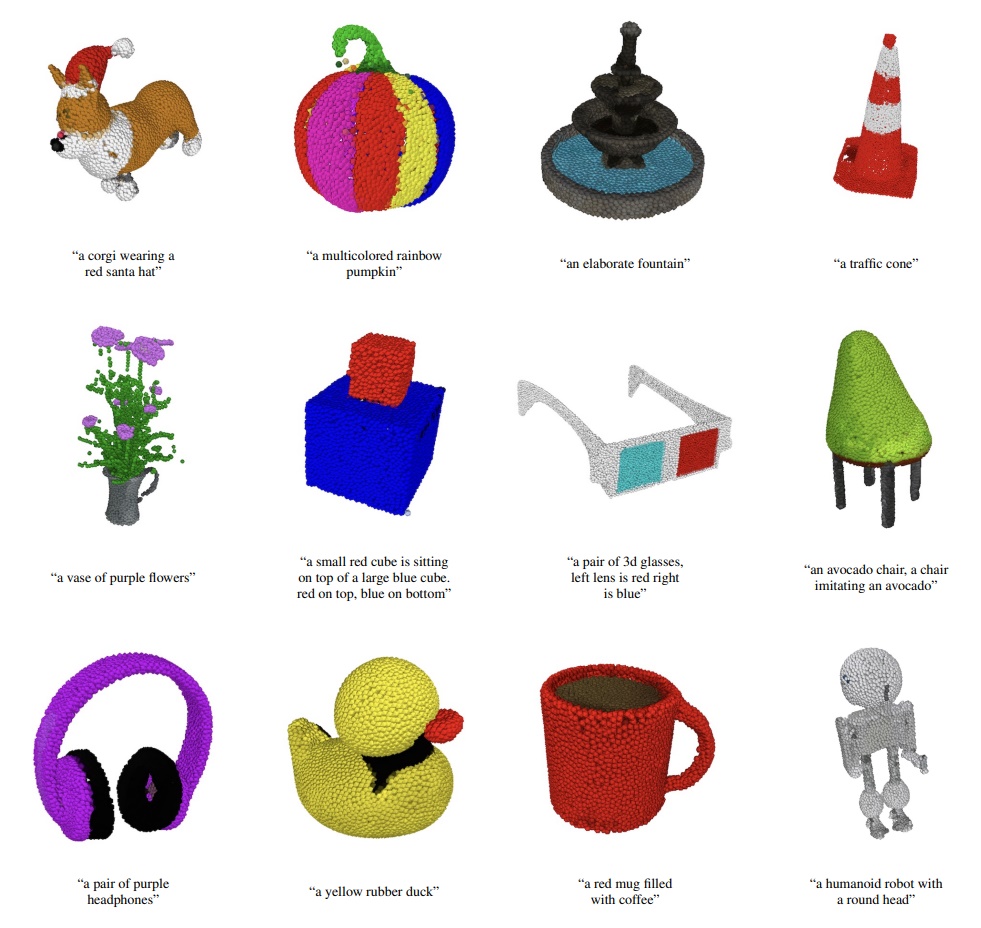

Esto se debe al método de generación en Point-E. El sistema utiliza nubes de puntos para representar al objeto tridimensional. Esta limitación reduce la precisión de ciertas características como la textura o la forma final, pero los objetos son mucho más fáciles de reproducir. El truco de Point-E para compensar esto es la conversión de la nube de puntos a mallas (léase «meshes»). En términos relajados, podemos hablar de tres modelos: Uno de texto a imagen, otro de imagen a nube de puntos 3D, y el tercero encargado del mesh.

OpenAI entrenó a este sistema con varios millones de objetos 3D, incluyendo metadatos. Ahora, Point-E suele cometer errores, en especial al momento de interpretar la imagen generada por el primer modelo, pero hay mucho trabajo por delante, que inevitablemente llevará a modelos más optimizados.

Sitio oficial: Haz clic aquí

Accede al estudio (PDF): Haz clic aquí