Una prueba bastante recurrente para medir la capacidad de una inteligencia artificial es enfrentarla a videojuegos. En el pasado hemos visto un par de ejemplos que involucran al número uno de Nintendo, pero en esta oportunidad las «víctimas» de la inteligencia artificial son 49 juegos de Atari 2600. Su nombre es Deep-Q, y lo único que necesitó fue entrenar cientos de veces con cada título.

Si bien no son pocos los que nos han advertido sobre la evolución de las inteligencias artificiales, eso no cambia el hecho de que hay muchos expertos trabajando y avanzando en dicho campo. Uno de los objetivos principales es que aprendan por sí mismas y tomen decisiones sin intervención humana, lo cual suena fascinante y peligroso al mismo tiempo. Si existe una actividad que obliga a una inteligencia artificial a aprender de sus errores, es jugar. Al principio, la IA ni siquiera sabe cómo mover a los personajes, pero con cada nuevo intento se vuelve más lista. Un poco de fast-forward a través de 600 o 700 partidas, y tenemos a una jugadora rápida, precisa, capaz de aprovechar errores de programación, y que se ubica a la par de un jugador humano.

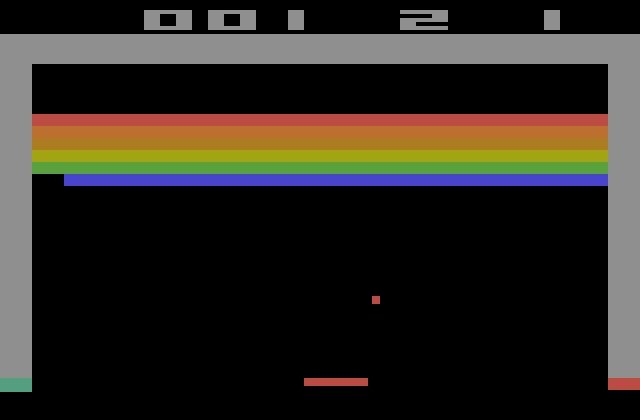

Eso nos lleva a Deep-Q, también conocida como Deep Convolutional Network, desarrollada por científicos de DeepMind, la rama de Google dedicada a la inteligencia artificial. En total, Deep-Q se enfrentó a 49 clásicos de Atari 2600, incluyendo a Breakout y Space Invaders. Sus responsables han destacado que la única información disponible para Deep-Q son los píxeles de la pantalla y el contador de puntos. A partir de ahí, Deep-Q debe asimilar los controles, comprender cómo sumar puntos, y por supuesto, tratar de no perder. Al ser comparada con Deep Blue, Demis Hassabis de DeepMind explica que son dos criaturas completamente diferentes. Deep Blue no fue otra cosa más que un programa depurado y optimizado con millones de movidas a su disposición, pero Deep-Q está basada en algoritmos que aprenden de cero a través de una experiencia perceptiva.

Algunos de los trucos que registró Deep-Q durante sus partidas son mantener a un submarino a salvo justo por debajo del nivel del mar en SeaQuest, y crear pequeños pasillos para golpear los bloques desde la parte superior en Breakout. Por ahora, Deep-Q ha logrado alcanzar más del 75 por ciento de las puntuaciones obtenidas por jugadores humanos. Los planes a futuro de los algoritmos disponibles en Deep-Q incluyen predicciones meteorológicas y la bolsa, pero los parámetros generales que buscan para Deep-Q son los de un niño de dos o tres años, y tanto Hassabis como sus colegas reconocen que aún están muy lejos de eso. Mientras no le enseñen Missile Command, creo que todo va a salir bien…