Como todos sabemos, la relación entre Intel y Nvidia está muy lejos de ser la mejor. Han tenido encuentros muy duros en el pasado, y como consecuencia es imposible ver a un procesador Intel funcionando en un chipset Nvidia. Sin embargo, las diferencias no terminan allí. Mientras que Intel defiende su modelo de procesadores basados en la arquitectura x86, colocando más núcleos en paralelo por procesador, en Nvidia están convencidos de que ese modelo de desarrollo de hardware es completamente obsoleto, y que ya no aporta beneficio alguno. Para ellos, la respuesta reside en utilizar cientos de núcleos a través de un eficiente procesamiento paralelo, algo que su sistema CUDA de GPGPU puede proveer.

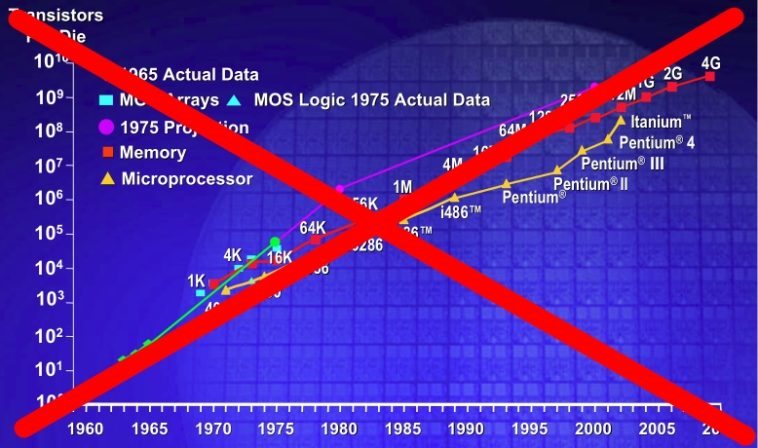

Veamos: La Ley de Moore indica que la densidad de transistores en un chip se duplica cada dieciocho meses. Con algunas idas y venidas, esta ley se ha cumplido en el contexto general. Hace diez años, la vanguardia estaba marcada por procesadores de entre 500 y 600 megahertz de velocidad. Hoy en día es posible encontrar chips con una velocidad de reloj de 2700 megahertz aún en las unidades más económicas. Como si eso fuera poco, la carrera de los megahertz dejó de tener sentido, y ahora el mejor procesador es el que más rendimiento ofrece en aplicaciones de hilos simples y múltiples. En otras palabras, la Ley de Moore no se ha vuelto algo inútil, sino que ha perdido parte de su efecto original. Hasta el hardware más sencillo ha tenido un desarrollo considerable, pero el aumento en la cantidad de transistores y núcleos entrega un aumento de velocidad cada vez menor. Algunos creen que este método de fabricación de procesadores ha llegado a un límite evolutivo imposible de sortear, y entre ellos encontramos a Nvidia.

La situación entre Nvidia e Intel es delicada, y por esta razón no se han ahorrado palabras al declarar "muerta" a la Ley de Moore. Pero esta declaración no llega por una simple cuestión de rechazo. El vicepresidente y jefe científico de Nvidia, Bill Dally, habla con fundamentos más que lógicos. Si bien la velocidad de reloj ha aumentado de acuerdo a los parámetros de la Ley de Moore, cualquier beneficio otorgado por el proceso de "escalabilidad" en materia de rendimiento puro está acabado. De acuerdo a Dally, es de una necesidad crítica construir nuevos ordenadores paralelos que sean energéticamente eficientes, y no concentrados en un aumento en serie de la velocidad. La ventaja de un sistema paralelo es que una duplicación efectiva de la cantidad de transistores se convierte en una duplicación del rendimiento. En cambio, duplicar la cantidad de transistores en un procesador convencional entrega un aumento modesto en el rendimiento, a costa de un terrible consumo de energía, haciéndolo altamente ineficiente.

Si bien Dally tiene algo de razón, lo cierto es que no termina de reflejar del todo la realidad de la informática. En primer lugar, las declaraciones provienen del vicepresidente de la empresa dueña del sistema de procesamiento paralelo mejor conocido, que es CUDA. Y en segundo lugar, no menciona en ningún punto al software. Hoy en día, soy muy pocas las aplicaciones que pueden aprovechar al máximo a un sistema que posea más de tres o cuatro núcleos. Tanto Intel como AMD se han visto forzados a implementar sistemas de aceleración en sus procesadores cuando ejecutan aplicaciones de un solo hilo, porque de una forma u otra, el software no está a la altura de las circunstancias. Y una teórica adopción del procesamiento paralelo implica abandonar a la arquitectura x86, algo que muchos desarrolladores no están dispuestos a hacer. La idea de Nvidia es buena, pero se necesitará mucho más que el CUDA y la declaración de su vicepresidente, para forzar un cambio en la forma en la que se crea el hardware hoy.